在当今信息爆炸的时代,大数据技术已成为推动社会进步和商业创新的关键驱动力。本次演讲将重点介绍大数据技术的核心组件及其处理流程,帮助大家全面理解这一领域。

大数据技术简介

大数据技术是指用于采集、存储、处理和分析海量、高增长率、多样化数据集合的技术体系。其核心特征常被概括为“5V”:体量(Volume)、速度(Velocity)、多样性(Variety)、真实性(Veracity)和价值(Value)。通过大数据技术,企业和组织能够从庞杂数据中提取有价值的信息,支持决策制定、优化业务流程和提升用户体验。

大数据核心技术

大数据核心技术包括数据采集、存储、管理和计算等多个方面。以下是关键组件的简要介绍:

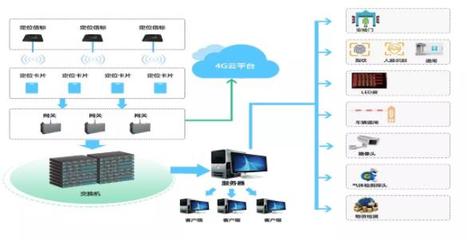

- 数据采集技术:这是大数据处理的第一步,涉及从多种来源(如传感器、日志文件、社交媒体)收集数据。常用工具包括Flume、Kafka和Sqoop,它们支持实时和批量数据导入,确保数据的及时性和完整性。

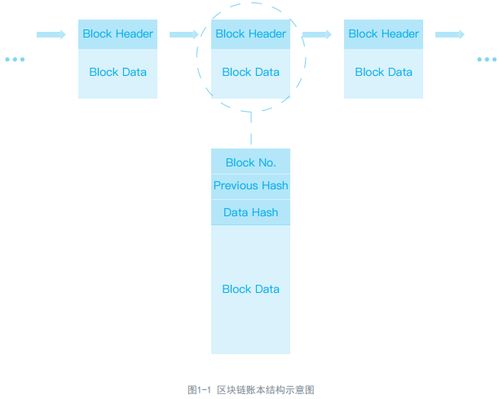

- 数据存储技术:针对海量数据的存储需求,传统数据库已无法满足,因此出现了分布式存储系统。例如,Hadoop HDFS(Hadoop Distributed File System)和NoSQL数据库(如HBase、Cassandra)能够提供高可扩展性和容错能力,支持结构化和非结构化数据的存储。

- 数据管理技术:在大数据环境中,数据管理涉及元数据管理、数据质量控制和数据治理。工具如Hive和Pig允许用户使用类似SQL的查询语言处理数据,而数据湖架构(如AWS S3)则实现了数据的集中管理和共享。

- 数据处理与计算技术:这是大数据技术的核心,包括批处理和流处理两种模式。批处理适用于离线数据分析,常用框架如Hadoop MapReduce和Spark;流处理则用于实时数据流,工具如Storm和Flink能够处理连续到达的数据,实现低延迟响应。

大数据处理技术

大数据处理技术专注于如何高效地分析和挖掘数据价值。根据处理方式的不同,可分为以下几种:

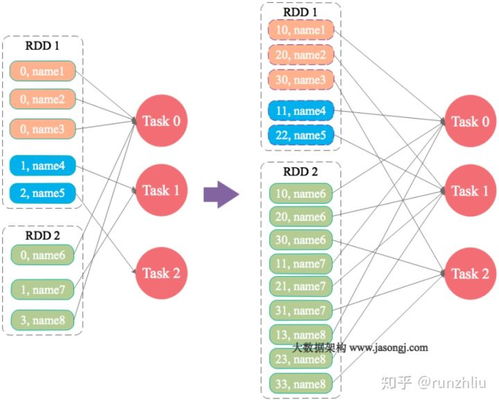

- 批处理技术:适用于对历史数据进行大规模分析。Hadoop MapReduce是经典代表,它将任务分解为多个小任务并行处理,但速度较慢。Spark作为改进方案,通过内存计算显著提升了处理速度,广泛用于机器学习和大规模ETL(提取、转换、加载)任务。

- 流处理技术:针对实时数据流,如金融交易监控或物联网设备数据。Apache Storm和Apache Flink是主流框架,它们支持事件时间处理和状态管理,确保数据处理的准确性和实时性。

- 交互式查询技术:允许用户快速查询大数据集,例如使用Presto或Impala,这些工具提供低延迟的SQL查询能力,便于数据探索和可视化。

- 机器学习与AI集成:大数据处理常与机器学习结合,框架如MLlib(Spark的机器学习库)和TensorFlow on Hadoop,支持从数据中训练模型,应用于预测分析和智能推荐系统。

结语

大数据技术通过其核心组件和先进处理手段,实现了从数据采集到价值提取的全流程自动化。随着人工智能和云计算的融合,未来大数据技术将继续演进,为各行各业带来更多创新机遇。掌握这些技术,不仅有助于应对数据挑战,更能驱动数字化转型的成功。谢谢大家聆听本次演讲!